基于Windows系统使用Ollama和ChatBox本地部署DeepSeek大模型的详细教程

一、设备要求

最低配置

- 系统:Windows 10/11 64位

- CPU:Intel i7 10代/AMD Ryzen 5 5000系列及以上

- 内存:16GB DDR4

- 存储:50GB可用空间(SSD推荐)

推荐配置(GPU加速)

- GPU:NVIDIA RTX 3060及以上(显存≥12GB)

- CUDA版本:11.8+

- 内存:32GB DDR4

- 存储:100GB NVMe SSD

二、部署流程

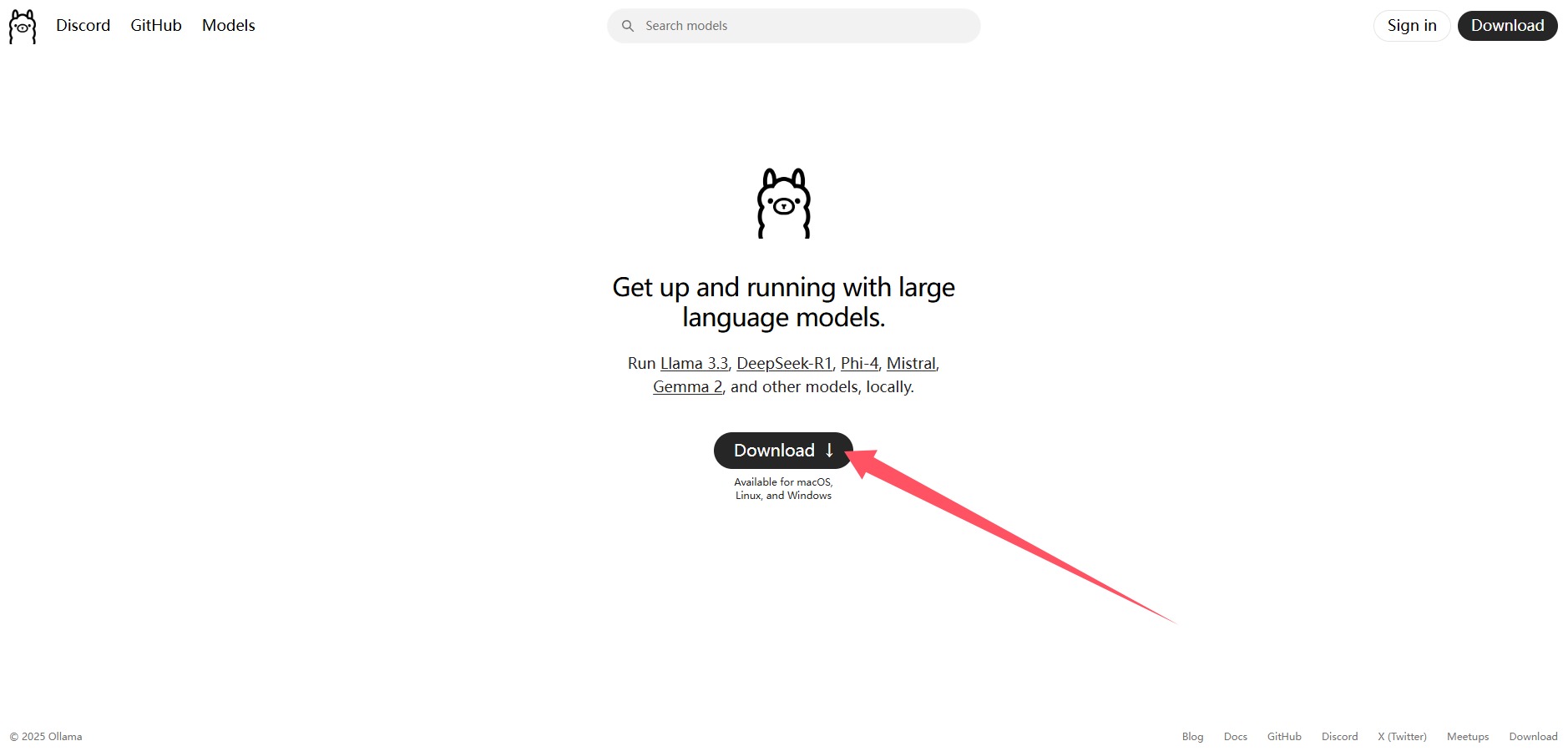

步骤1:安装Ollama

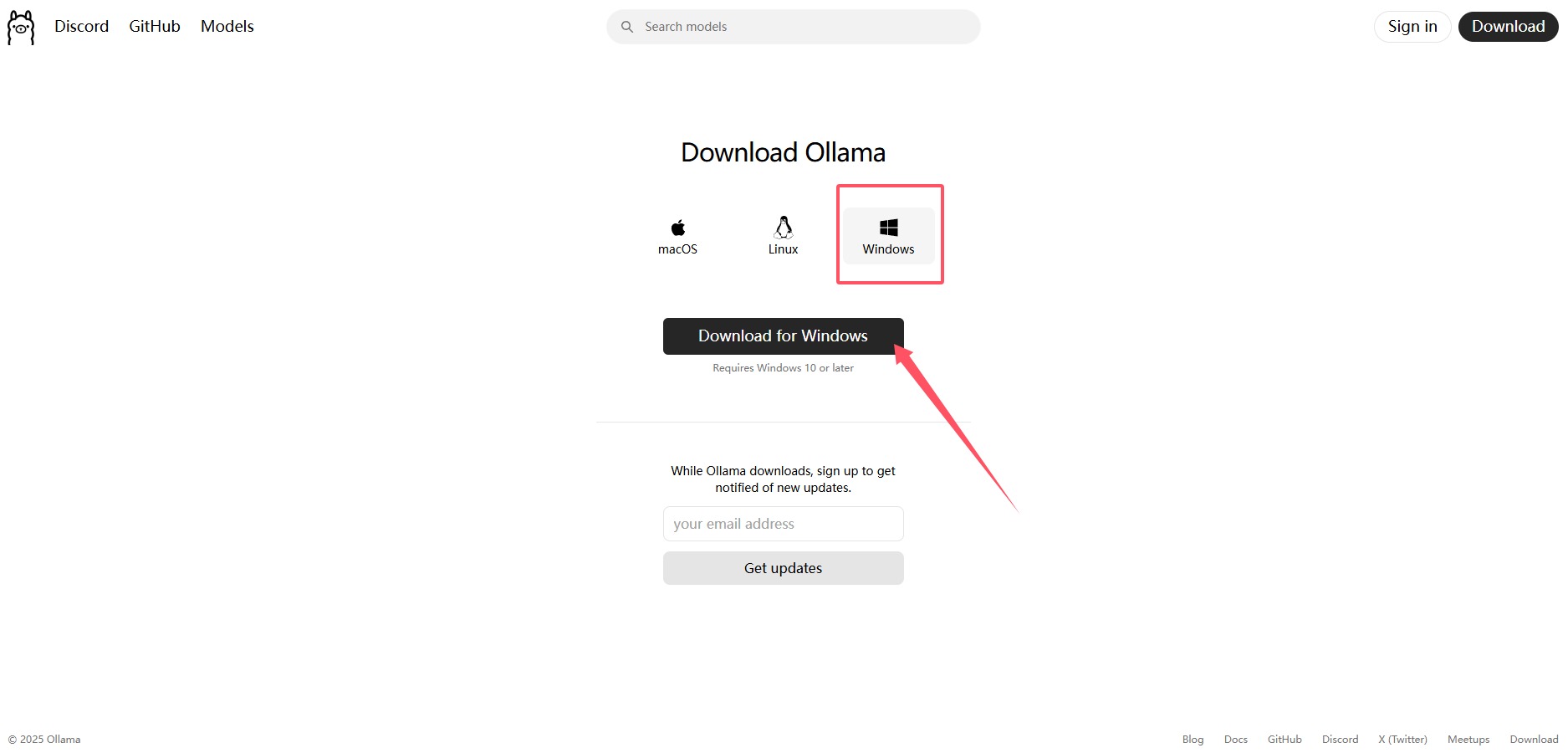

- 访问 Ollama官网,下载Windows版安装包。

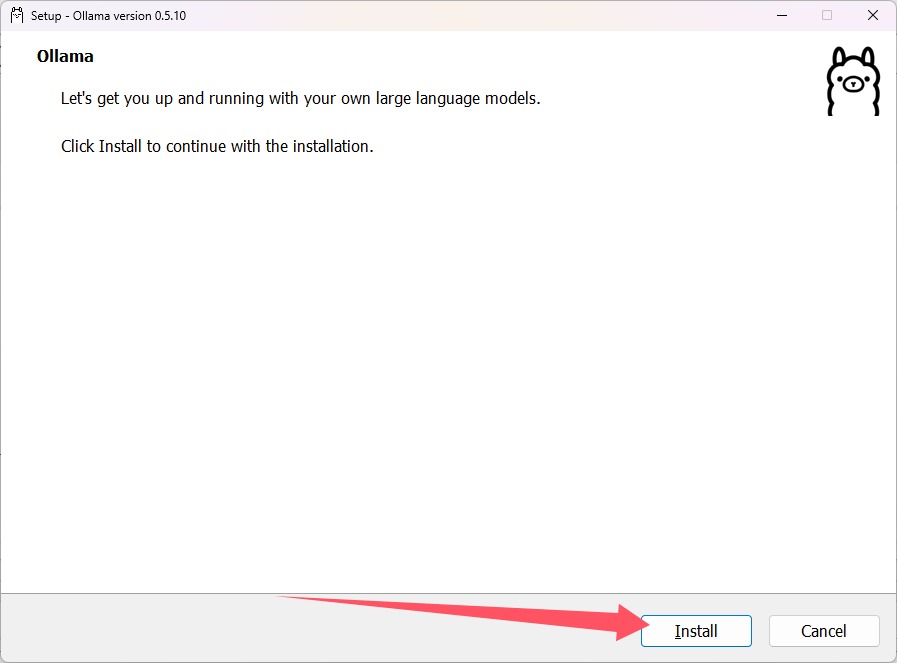

- 下载ollama后双击安装包完成安装(默认安装路径为 C:UsersAdministratorAppDataLocalProgramsOllama)。Administrator为用户名。

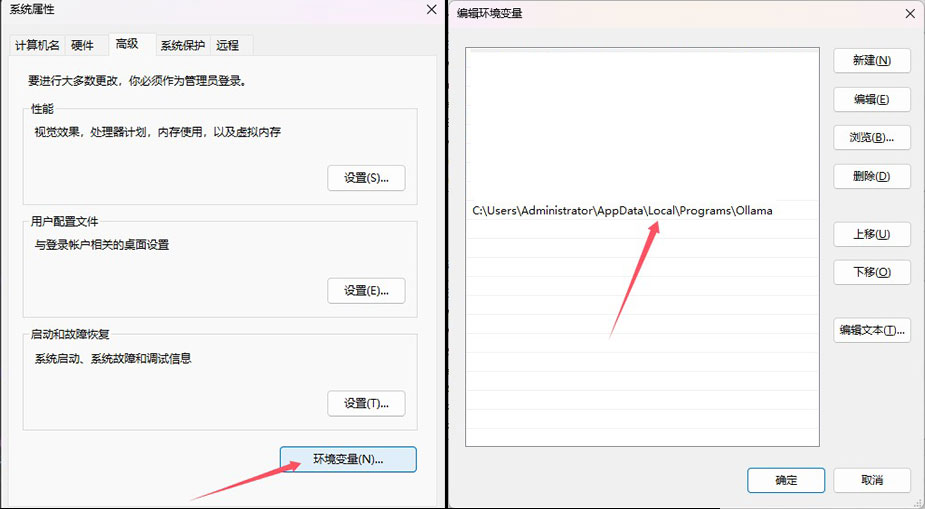

- 配置系统环境变量,在path中添加 ollama安装路径。

(windows左下角点击搜索,输入ollama,鼠标右键-打开文件位置-若是ollama的快捷方式继续右键-打开文件位置进行查看安装路径)复制安装路径到path中。

如:C:UsersAdministratorAppDataLocalProgramsOllama

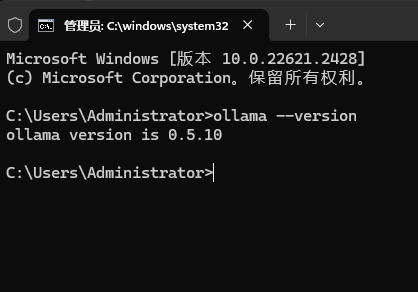

- 验证安装是否成功。按下win+r输入cmd回车。输入:

ollama --version

注:若提示命令不存在,需手动添加Ollama到系统环境变量

注:若提示命令不存在,需手动添加Ollama到系统环境变量

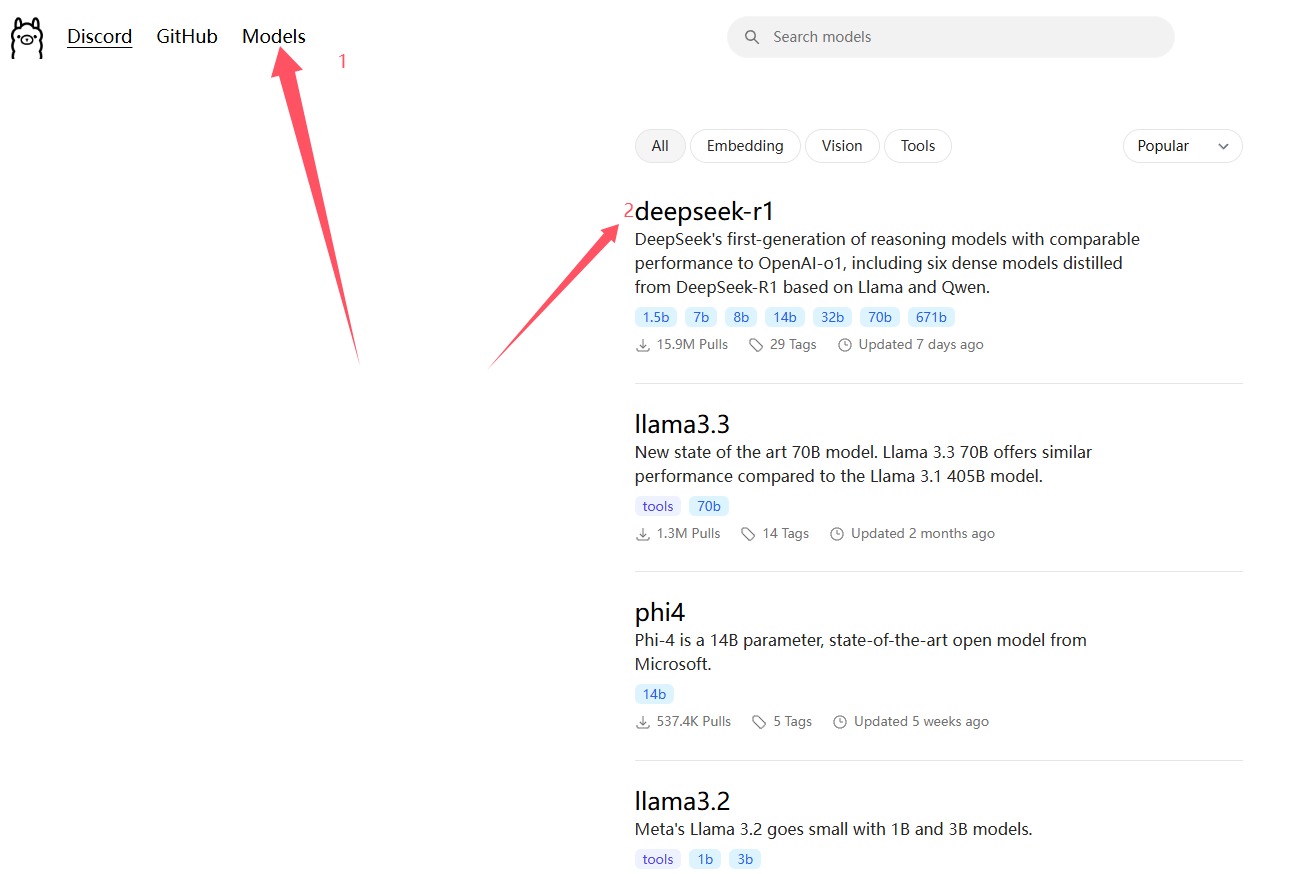

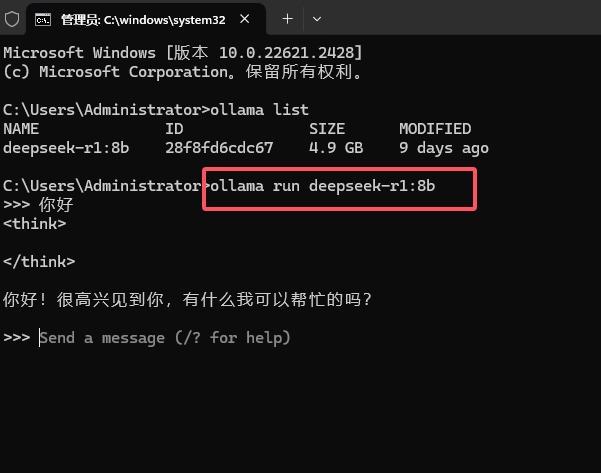

步骤2:拉取DeepSeek模型

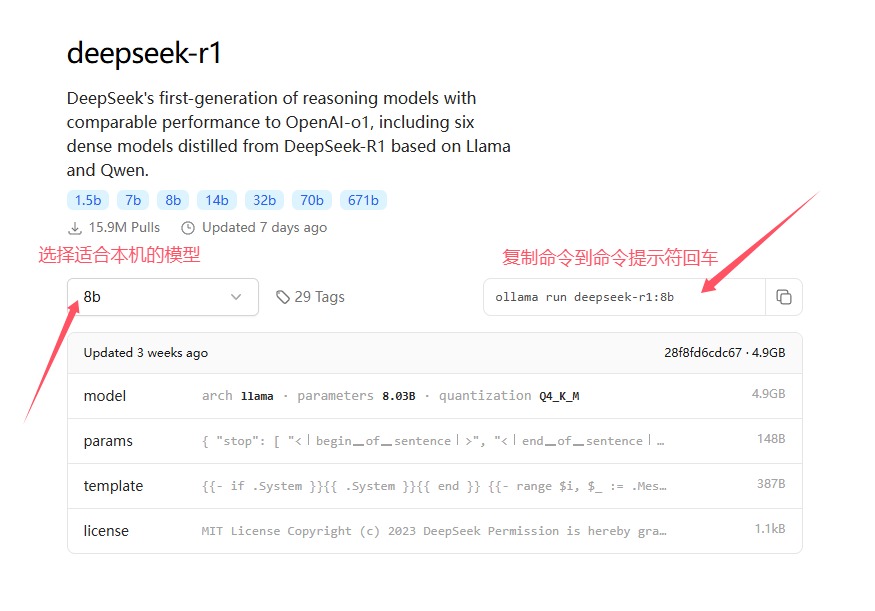

- 在ollama官网点击models,选择deepseek-r1并选择适合参数的模型,以8b为例

- 将命令粘贴到命令提示符中,回车,耐心等待安装完成。

- 至此安装完成后可在命令提示符中进行对话。

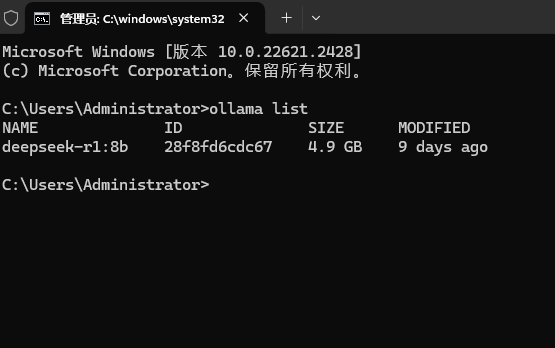

若安装有多个模型,可输入ollama list

进行查看,可输入:ollama run 模型名称进行切换

步骤3:安装并配置ChatBox

- 下载ChatBox:

- 访问 ChatBox官网 https://chatboxai.app/下载Windows客户端。

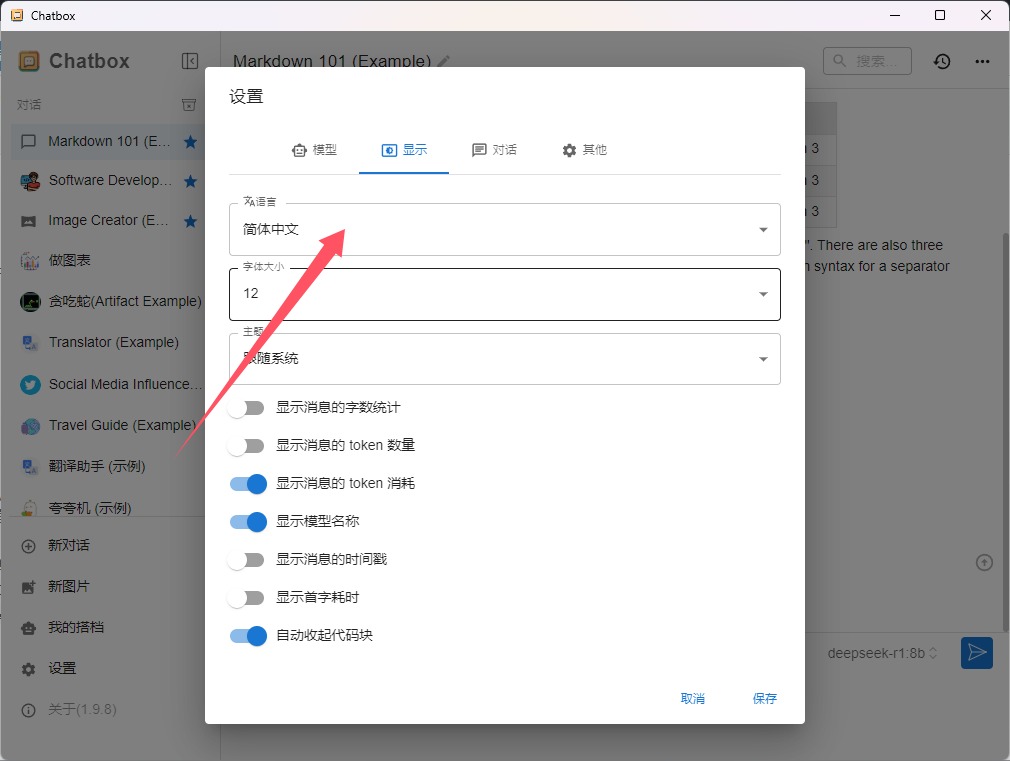

- 安装后打开,进入设置界面,点击显示,选择中文。

- 访问 ChatBox官网 https://chatboxai.app/下载Windows客户端。

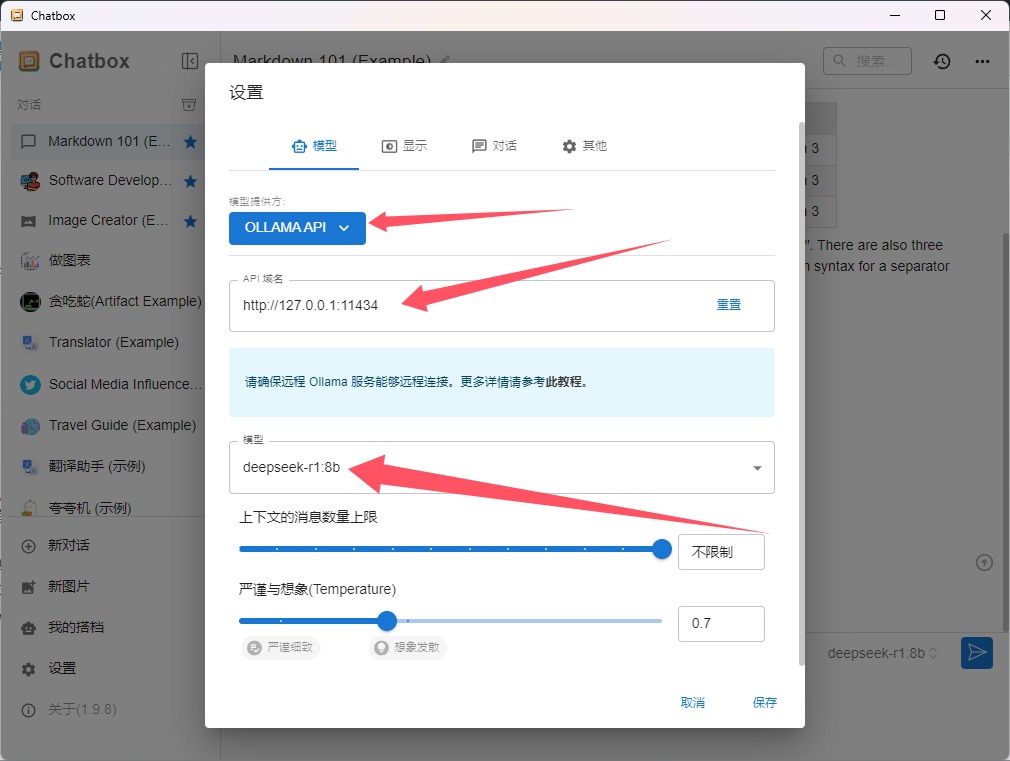

- 连接Ollama服务:

- 在ChatBox中配置自定义API:

- API地址:

http://localhost:11434或http://127.0.0.1:11434 - 模型名称:

deepseek-llm-7b(选择此前安装的模型即可,)

- API地址:

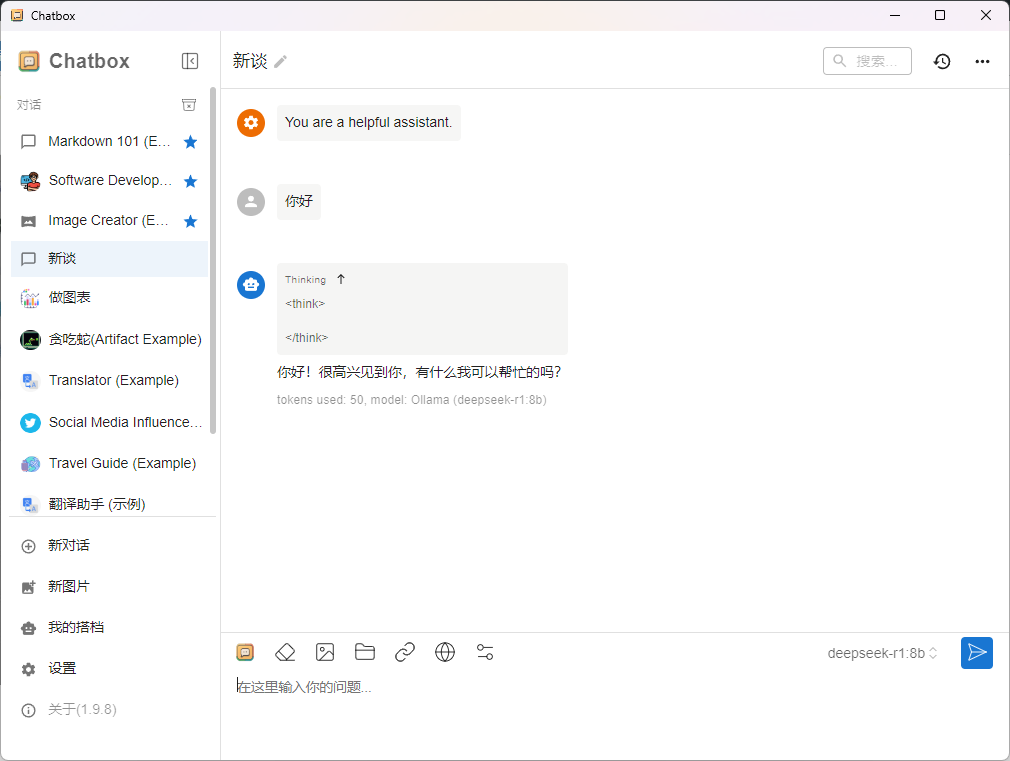

- 保存配置并测试连接:

- 点击新对话开始对话即可

- 在ChatBox中配置自定义API:

至此本地部署deepseek完成。

四、常见问题

| 问题 | 解决方案 |

|---|---|

| 模型下载失败 | 检查网络代理或使用镜像源 |

| ChatBox连接超时 | 确认Ollama服务已启动(端口11434开放) |

| 中文输出乱码 | 在Ollama启动命令中添加--encoding utf-8 |

| GPU未调用 | 更新NVIDIA驱动并安装CUDA Toolkit |

五、注意事项

- 模型授权:商用需联系DeepSeek获取许可。

- Windows限制:Ollama对Windows的GPU加速支持有限,建议高性能场景使用WSL2。

- 资源占用:运行模型时关闭其他大型应用以释放内存。

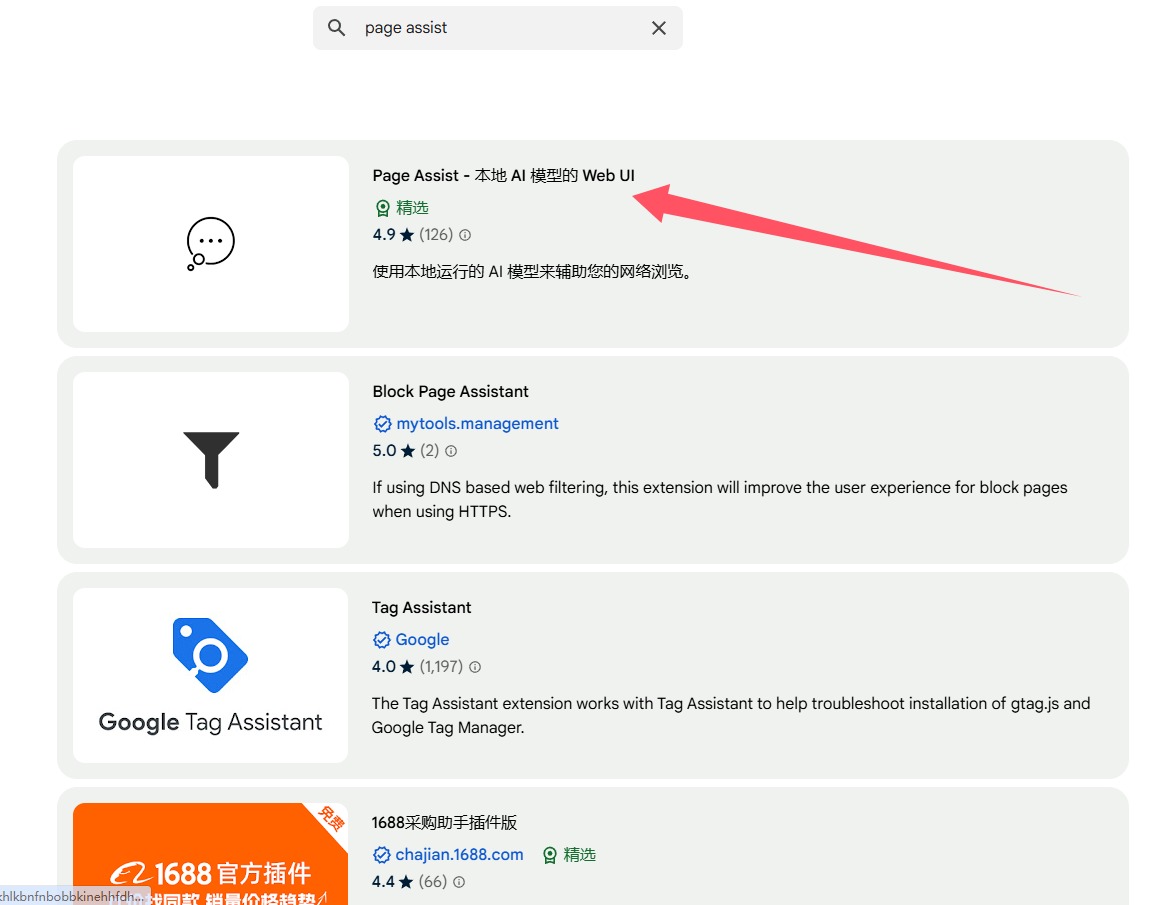

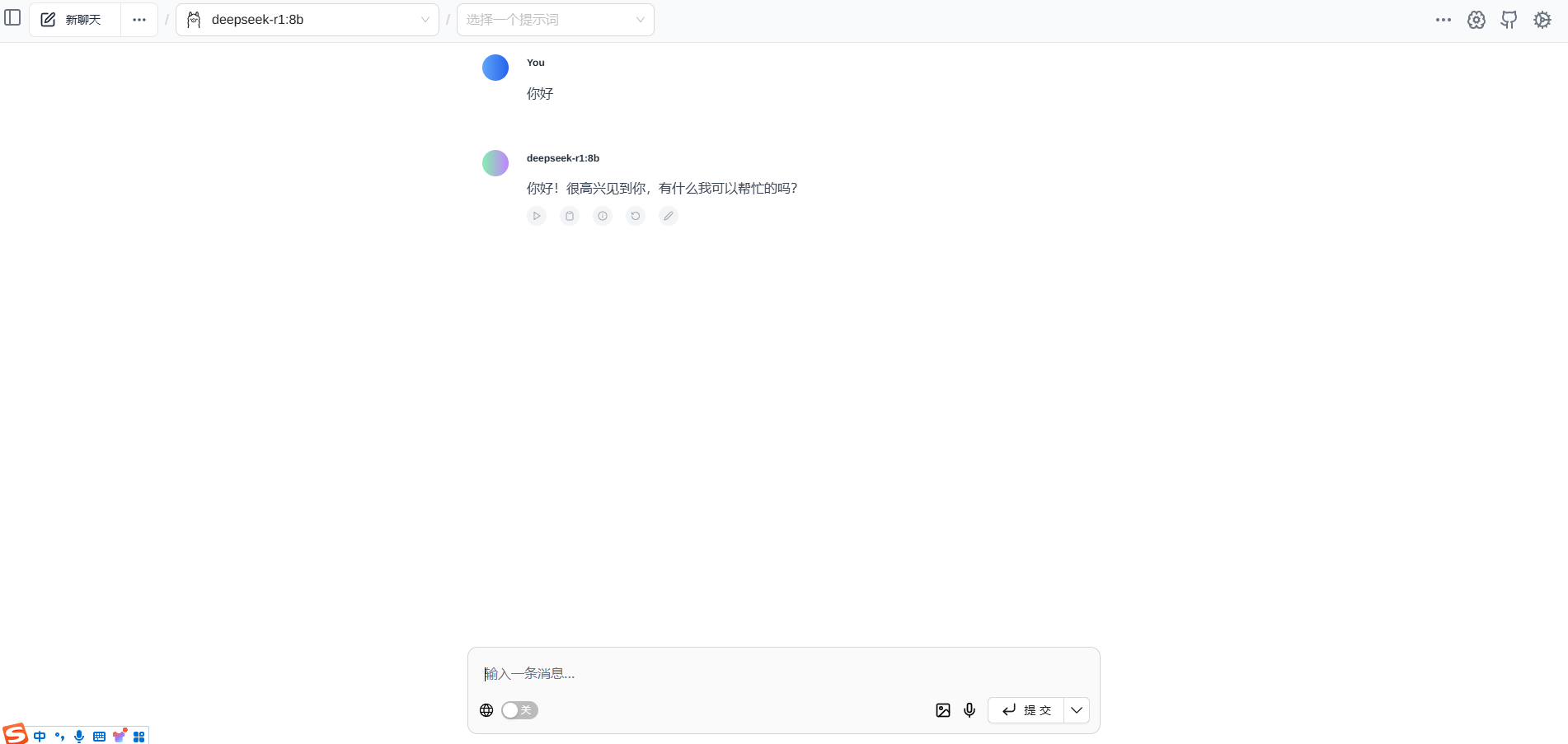

六、使用WebUI美化

若不想下载chatbox软件可使用WebUI

- 在chatbox官网点击启动网页版即可,设置模型等与APP设置相同。

- 使用谷歌浏览器Page Assist插件启动。访问https://chromewebstore.google.com/?utm_source=ext_app_menu进入应用商店,下载Page Assist插件安装,Ctrl+Shift+L即可打开对话界面,选择对应模型即可聊天。无梯子下载插件文件到本地后安装:

***此处内容登录后可见***

温馨提示:此处为隐藏内容,需要登录后可见

登录查看

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。

评论(0)